简介

OpenVINOTM是优化和实施人工智能推理的开放源码工具箱。

- 在计算机图形、自动语音识别、自然语言处理和其他大众应用方面,深层学习成绩有所改善。

- 利用利用诸如Tensor Flow、PyTorrch等流行框架培训的模型。

- 资源需求正在减少,从边缘到云层的一系列英特尔平台正在更有效地部署。

由于作者的项目开发需要加快OpenVINO针对YOLOV5的推理速度,这项工作主要是加速YOLOV5的模型转换和推理速度,与其他模型基本平行。

模型转换

pt To ONNX

利用 YOLOV5 源文件的导出。 Python 脚本可以快速将yolo 训练过的 pt 模型转换为通用的 onnx 模型 。

Yolov5 的模型目录

pt 模型可立即转化为 Anonx 模型。

ONNX To IR

OpenVINO推理加速在部署工具/最佳推理器线路下采用了中间模型,该模型还提供了一个脚本,用于将ONNX模型转换为以自己的模型优化器转换成IR模型的IR模型。

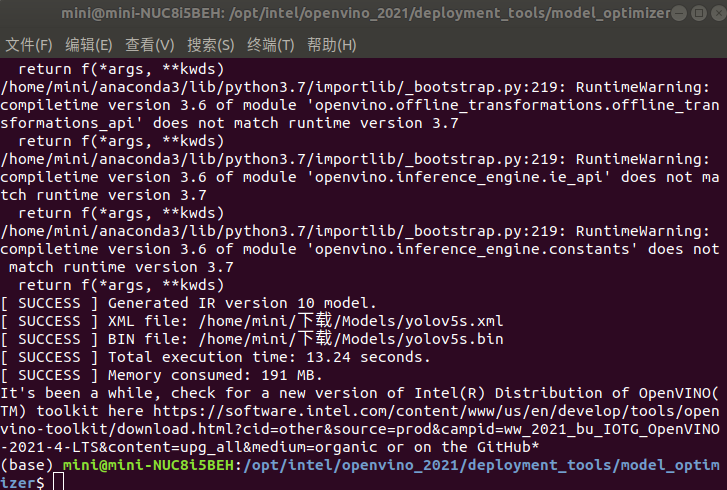

运行模型转换脚本

SUCCESS 的外观显示转换成功, 文件. xml 和. Bin 将在正确的路径. xml 和. Bin 文件下创建, 您必须随时将这两个模式文件置于一个一致路径下 。

推理加速原理

OpenVINO利用不要求示范再培训的滚动神经网络加速推理。

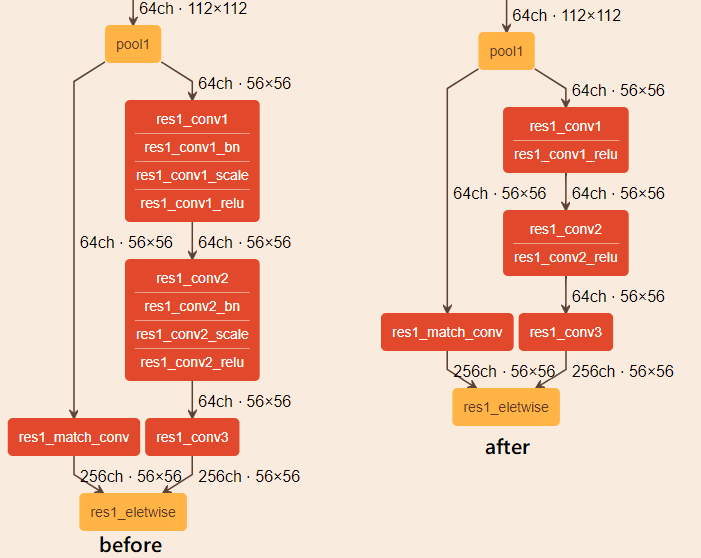

线性操作融合

曲线神经网络包括:BatchNormalization和ScaleShift图层(例如,Resnet*Inption*)可称为线性计算顺序:可合并的增量和乘数。Convolution要么FullyConnected层。

印章优化(ResNet优化)

ResNet优化是优化的一个子集。ResNet50、ResNet101、ResNet152和其他使用咖啡类ResNet和ResNet播种的播种方法的播种方法。优化的主要理念是从内核大小=1到上体积跨一步以上。 此外,模型优化器增加了一个池层。

推理步骤

1. 搭建推理环境

2. 执行推理

3. 后处理

在不同的网络模型中,相应的后处理方式各有不同,在不同的网络模型中,仅以广义提供参考。

参考

Converting a Model to Intermediate Representation (IR)

Model Optimization Techniques

后续

如果你选择的话, 你可以集中关注我的公共开发圈, 特别是那些对深层学习和电脑可视化感兴趣的朋友, 我会分享所需的源代码和更多关于它的信息, 或许是为了帮助新人!