这篇文章是全球之声在线特稿的一部分。CvT尽管在标题上有一卷,然而,变形集团仍然是最受欢迎的集团。在Token的治疗中引入了数量。因此,模型的位置。最终CvT占Top1精度的87.7%。

引言

CvT设计中的动机部分也为愿景转换器结构增添了地点。采用地方化预计将带来更多的业绩和效率取舍。因此,我们专注于CvT引进地点的方式。提出了两项具体的改进建议:

- Convolutional token embedding

- Convolutional Projection

通过以上改进,模型不仅具有体积的好处(当地对野生、权重分担、空间下取样等特征的优点的认识,等等)。当您更改形状、 缩放、 旋转等时, 保持恒定 。它还保留了自我关注的好处。例如,动态关注、全球语义信息、提高一般化能力等等。

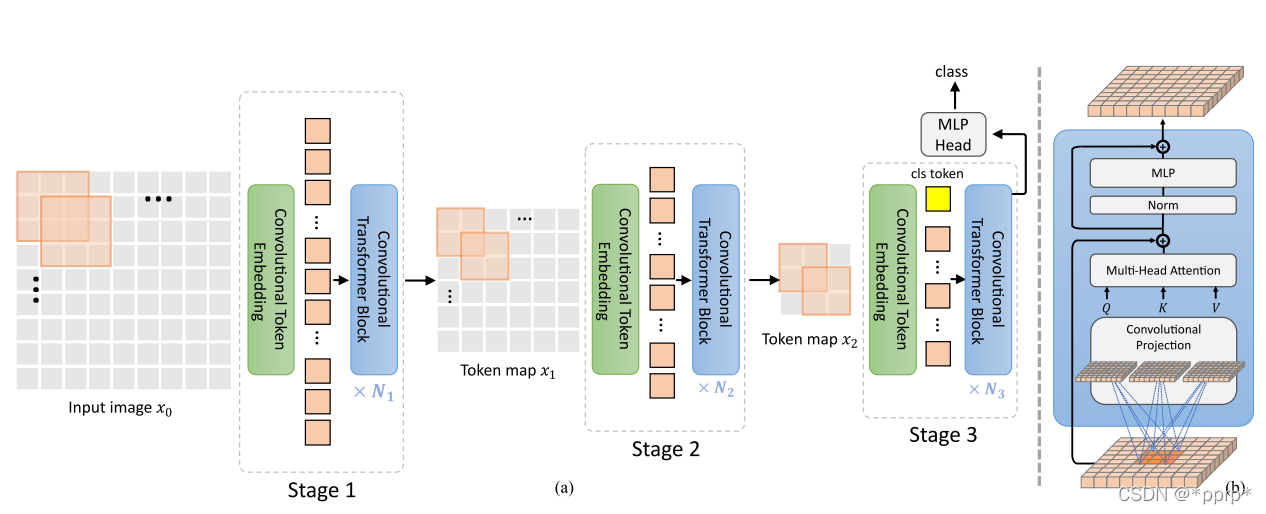

进化愿景变异器由两个主要部分组成:

- 第一步,参考CNN的架构,变换器还以多阶段等级的形式产生。每个级别之前都有一个非动态象征性嵌入器。分解功能可通过使用体积+层叙述来实现(注:逐步缩短顺序长度)。每个象征的维度应加在一起。这相当于总量的一半。通道数增加的操作)

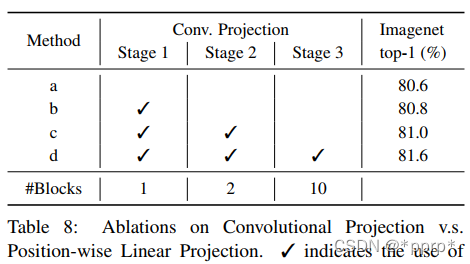

- 将旧的线性工程替换为“ 无法初始化 Evolution ” 第二阶段的 Evolution 邮件组件。 模块真的使用深度可分离量的实现来正确捕捉本地语义信息 。

应当提及的是,CvT删除了定位嵌入模块,没有观察到对模型性能的影响,认为在改变分辨率的情况下,结构的设计可以简化,更便于调整。

比较

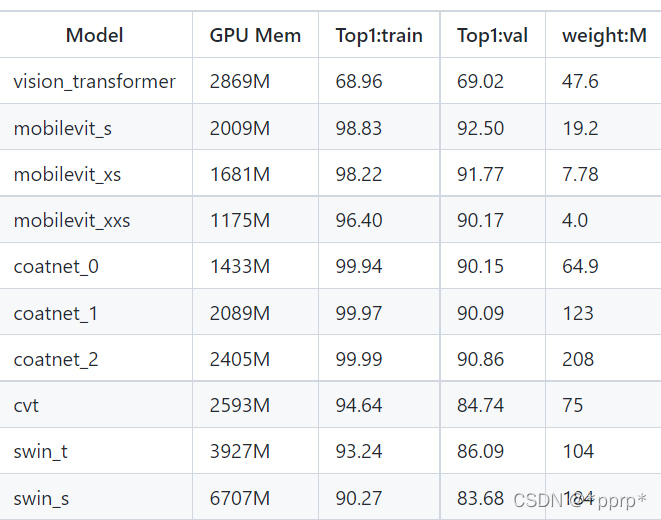

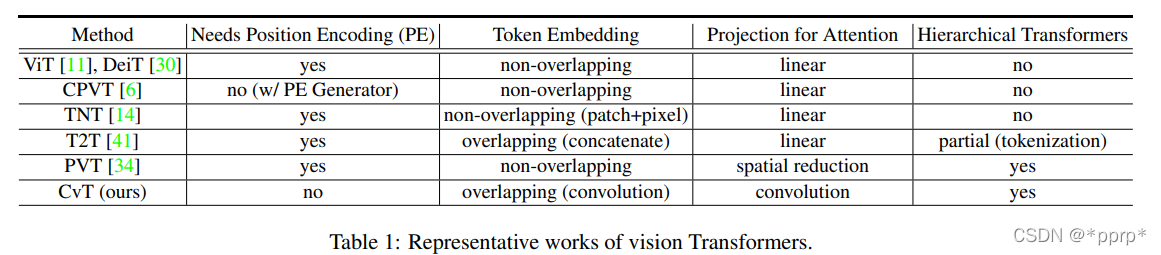

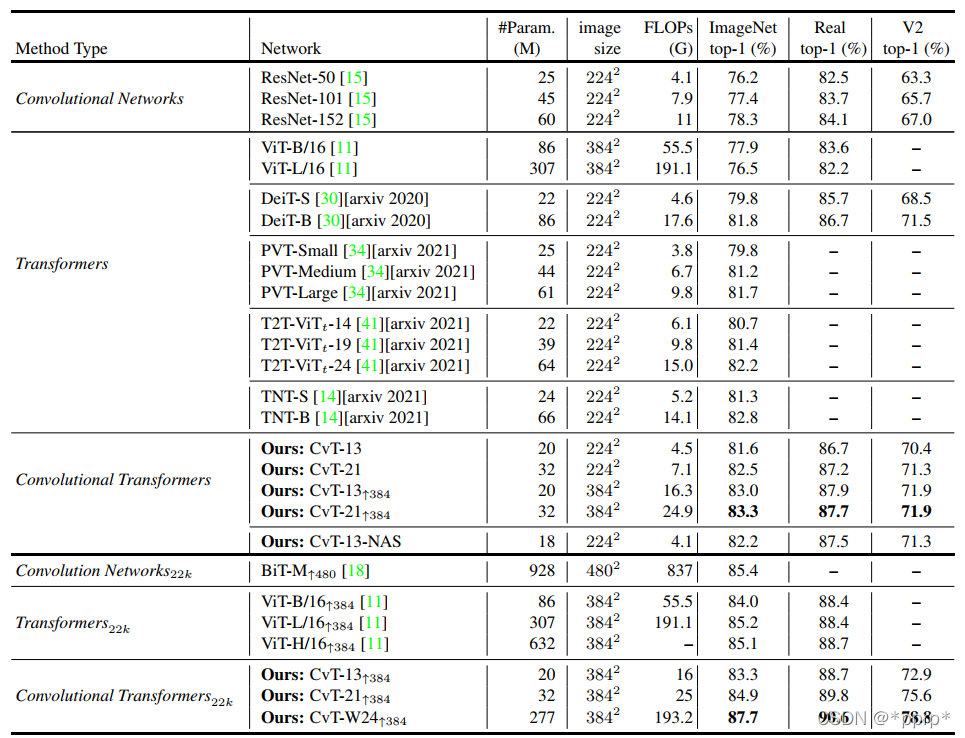

CvT总结了在适当的工作领域比较比较比较比较比较的表格:

方法

导言中提供了大量补充资料,下面是结构图摘要(以尽可能简单的语言):

- 绿箱是一种装饰性嵌入程序,一般而言,它使用超大容量,增加了当地赤字。

- 在右边的蓝色框中显示增强的自我放大,一般采用非本地操作,即使用深度分离体积来取代MLP来实施,如下图所示,在右侧的下图中显示,显示增强的自我放大,一般使用非本地操作,即使用深度分离体积来取代MLP来实施,如下图所示:

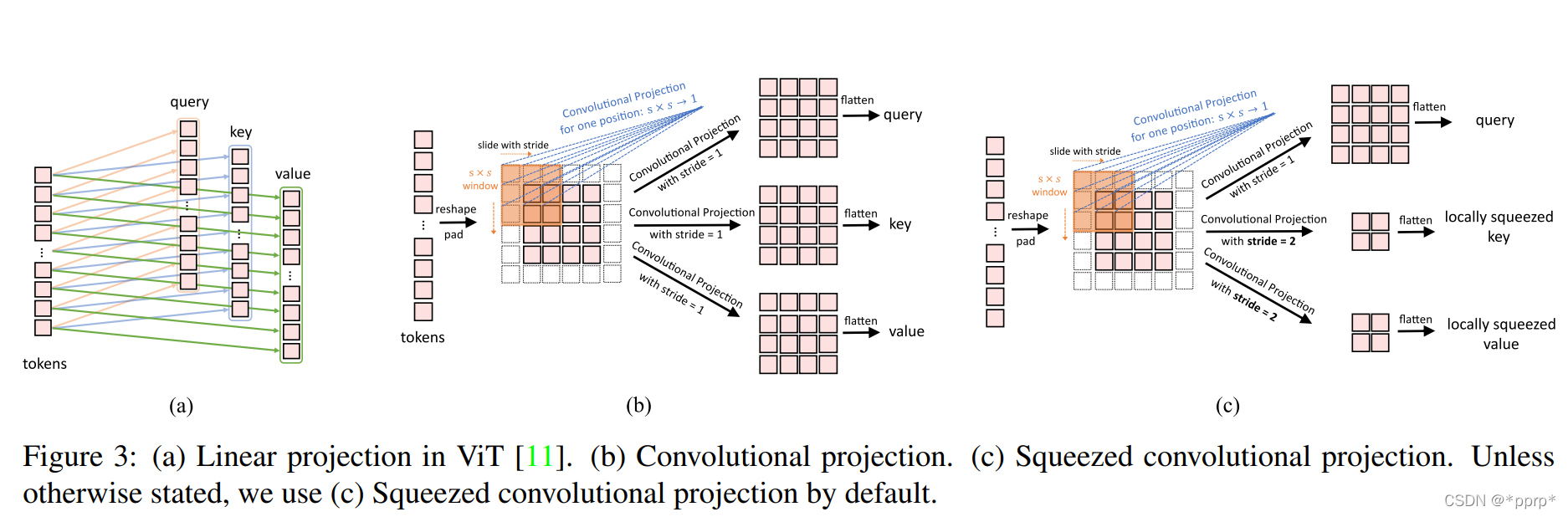

- 如图(a)所示,愿景变换器利用多边定位程序执行线性项目,这一信息具有全球性质,但用更多数字计算。

- 如图(b)所示,地图是用数量制作的,与非本地网络所使用的方法相似。

- 如图所示,带有大步的体积被压缩,这被认为是有效的,象征性物的数量可以减少四倍,导致性能略有下降。

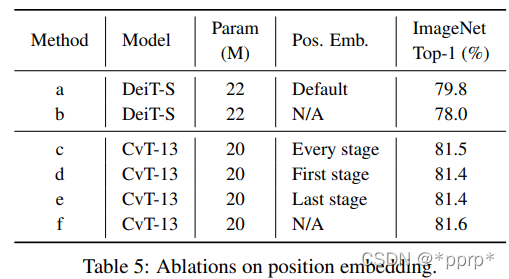

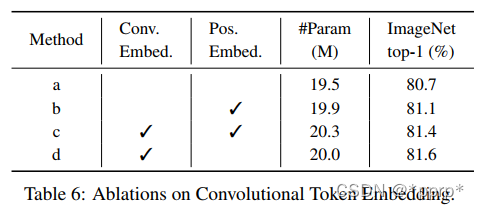

邮政嵌入调查:

利用 " 化化 " 项目是不可行的,因为每个变换器区块都使用该项目。本项目是我们对2011年中国选举的特别报道的一部分。它们可以模拟当地空间联系,其细节足以模拟模型。因此,我们可以解除变压器的后置嵌入程序。从下表发现,Pe对模型性能影响极小。

与其他工作的对比:

- 同期工作 1: 托肯对肯VT:利用进步化实现近乎象征性的融合虽然以变换器为基础的主干网是本地化的,但它还是因特网发展的工具。它还缩短了象征性序列。

- ** 区别:** CvT采用多阶段程序,在提高标牌尺寸的同时降低标牌长度,从而确保模型的容量。同时,与T2T相比,计算结果有所改善。

- ** 同期工作:** 金字塔愿景变异器(PVT):金字塔结构已经推出,这样光字塔可以用作高密度预测项目的后骨。

- ** 注:**CvT同样采用金字塔设计,但在CvT中,建议利用跃进量进行空间取样,从而纳入更多的当地信息。

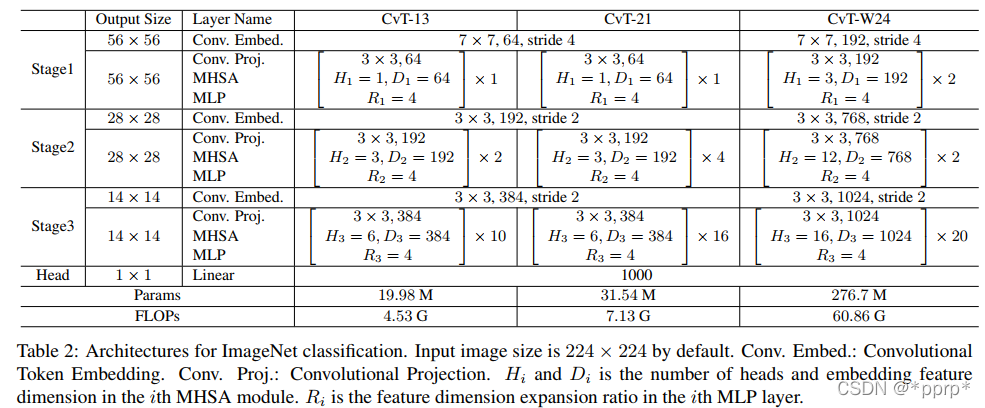

最终模型架构如下:

实验

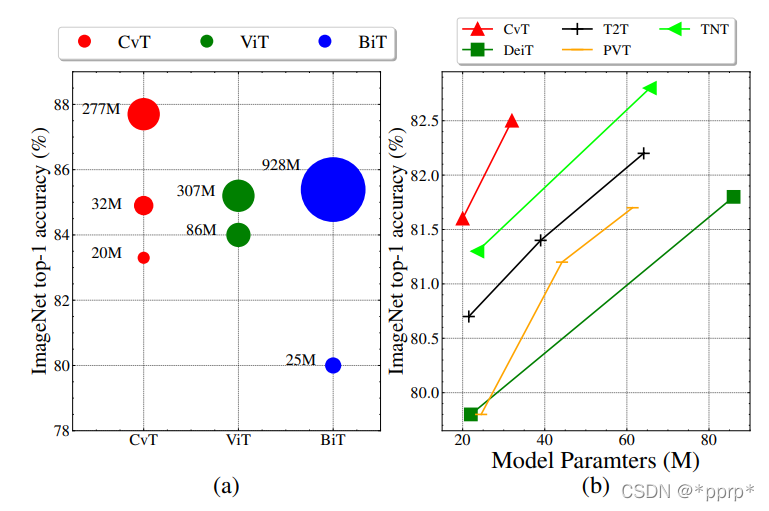

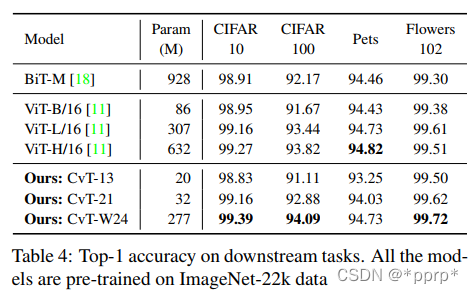

BIT是左边最吸引人的地方这是谷歌一篇文章的一大笔传输。这是关于CNN的结构如何影响 大规模的数据和培训。即使是纯净的CNN建筑模型,也可以包括大量参数,正如所显示的那样。同样精确地说,视野变异器、CvT等模型参数大大低于Bitt。这在一定程度上解释了当数据充足时,变形器与CNN可如何配合运行。它的表现优于CNN基本结构模型。

正确数字将CvT与其他服务变压器结构的性能进行比较,表明CvT是一个非常良好的交换。

与SOTA比较:

有趣的是,CvT-13-NAS还采用DA-NAS搜索技术,主要可搜索关键和价值进步,以及MLP的扩展比率,其搜索结果比基线要好一些。

当不需要 JFT 数据集时, CvT 可以修改87.7% Top1 精确度 。

其他数据集结果:

消融实验

代码

折叠式托肯嵌入代码已经实现:可以观察到,它是大号幻灯片导言 + 大号幻灯片介绍 的所在地点。

无法启动 Evolution 的邮件组件 。

参考

https://github.com/microsoft/CvT/blob/main/lib/models/cls_cvt.py

https://arxiv.org/pdf/2103.15808.pdf

https://zhuanlan.zhihu.com/p/142864566

我改变了CvT数据集中的参数,例如Stride,这是Cifar10数据集的一部分。下列成果是在没有使用任何数据扩增或操纵的情况下产生的。第一个是84.74这并不是说它没有看起来那么好, 但是它没有看起来那么好。然而,这一点尚未得到考虑,而且增加了数据扩充方法。仅学习了200个时代的成果。

感兴趣的国家可联系到以下环节:

https://github.com/pprp/pytorch-cifar-model-zoo